2022年OpenAIが発表した対話型AI「ChatGPT」の衝撃は、米国ビックテック最強の一角であるGoogleをも動揺させた。Googleは急ぎ「Bard」と名付けたAIチャットボットを投入し、巻き返しを図ることになる。

ユーザーから見ると急展開に心が躍る一方、果たしてこの戦いは本当に意味や意義のあるものになっているのか?

chatボットの歴史から見てハラハラする気持ちもありつつ、日本人がここ迄短期間で熱くなるのも少々冷静に見て行きたい。

YouTubeでも早速、広告収入や登録者数を増やす目的に同じように視聴者獲得に余念がない。

まずは現状のAIチャットボット関連をまとめ、それからチャットボットの歴史を振り返り、現状、そして未来を考察。

2023年:DL(深層学習)チャットボット百花繚乱

最近になってDLをベースとしたチャットボットが注目を集めている。OpenAIのChatGPTについてはもはやSNSで拡散しまくっているで説明不要だろう。GoogleのBard、そしてOpenAIに資金投入するMicrosoftによる「Bing+ChatGPT(GPT4)」の登場も間近と言われている。他にもチャットボットではないが「Perplexity.ai」のような新しい検索サービスも登場している。

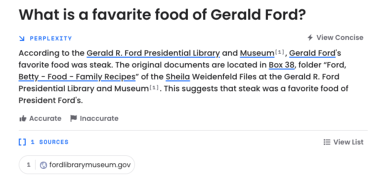

例えばPerplexity.aiに「1975年のアメリカ大統領は誰か?」と聞いてみる。

Perplexity.aiは、検索エンジンのように答えを返してくる

DLの出力内容は「ジェラルド・フォード」であった。

本当かどうか調べたければ、出典として掲出されているWikipediaのページを見ると、1974年にニクソンから政権を引き継ぎ、77年にカーターに政権を引き渡したことまで分かる。

最大の特徴は根拠言わば引用文献迄明記することだ。

これはGoogle社が世界中の情報を整理し、全ての人に使いやすく提供することも組み込み、より正しい情報或いは過去の検索結果や自然言語処理課程でユーザーがたどる行動パターンを学習しての出力だろう。

Perplexity.aiのサービスが注目を浴びているのは、チャットではないものの、出典が明記されることで、従来の検索エンジンの使い勝手のままDLの恩恵を得られる点だ。

また、回答の詳細を説明させることもできる。さらに「フォローアップ」として、この質問の答えに関連した質問もできる。これが従来の検索エンジンと違うところで、ニューラルネットワーク開発の賜物だろう。

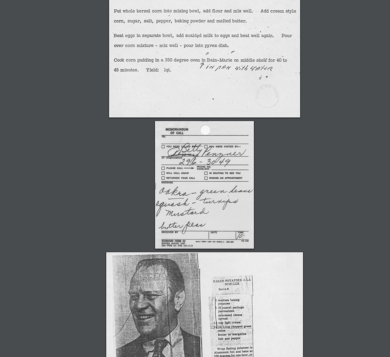

続けて「ジェラルド・フォードの好きな食べ物は?」と聞いてみる。普通の検索エンジンなら答えに辿り着くのはかなり難しいはずだ。すると、すぐさま「ステーキとポテト」が好きだったという記録が出てくる。

その出典は、なんとフォード博物館の記録で、フォードの妻、ベティのファミリーレシピがPDFファイルとして示される。そして実際にベティ・フォードの得意料理のレシピまで、タイプライターで打ち出された文章がそのまま掲載されている。

これぞ皆が絶賛して所以ではないだとうか。普通に検索してここに辿り着くのは非常に困難である。

Perplexity.aiに比べると、ChatGPTはかなり怪しい答えでも自信満々に返してくる(ユーチューバー等が実践し動画配信してるので割愛)。このあたりが洗練されているとは少し言い難い。

ではChatGPTがこのまま進歩していけば、正確な答えを返すチャットボットになっていくのだろうか?

それを考えるために、MetaのAI研究機関トップのChatGPTに関するコメントを見ておこう。

Meta社の研究期間である旧Facebook AI Research(FAIR)が公開している「ParlAI」は、かなり前からDLによるチャットボット機能を搭載していた。このParlAIのチャットボットは、Amazon Mechanical Turkで集められたクラウドワーカーとの会話をデータセットとして学習している。

AIの第一人者として知られるヤン・ルカンが関わった「ParlAI」

このデータセットは、まずクラウドワーカーが生徒役と教師役に分かれ、教師役はWikipediaのランダムな項目について説明文を要約し、生徒役は要約に対して質問、教師役は質問の答えをWikipediaの記述から探して答える、という大掛かりなものだ。これが2年も前のことである。

最近、Facebook AI ResearchあらためFundamental AI ResearchことFAIRのヤン・ルカン(AIの第一人者として知られる)は、「ChatGPTは革命的ではない」という主張をした。自分達も数年前からDLによる会話データセットの構築とそのオープン化を推進していたので、これは当然の主張だろう。FAIRは今現在、最も主流といわれるDLフレームワークPyTorchの開発元でもある。

そしてルカンは次のように発言している

「規模(量)を大きくすれば会話の質が上がるわけではない」と。

なにせ、DLによるチャットボットを何年も作っているチームのトップの発言である。

小生も同様だ。だからChatGPTの延長線上に、果たして欲しいものがあるのかどうかには疑問が残る。

なぜ規模を増やすだけではダメだと思うのか、そして同時に、なぜ日本人は、ChatGPTに振り回されてしまっているのか、それをひも解くにはチャットボットの歴史を振り返る必要がある。

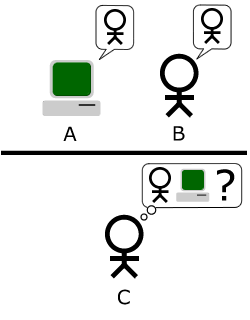

「隣の部屋にいるのは女性か、女性の振りをした男性か、それとも女性の振りをするAIか?」

コンピュータ黎明期に多大な貢献を果たした人物の一人に、アラン・チューリングという人物がいる。

チューリングの貢献がどれほど重要なものであったか、この業界の人なら知らぬものはいない。

コンピュータの世界でのノーベル賞に相当するのは、アメリカ計算機科学会(ACM)のチューリング賞であることからもその功績がうかがえる。ちなみにルカンはチューリング賞受賞者である。

チューリングが晩年行った研究テーマのひとつは、非常に奇妙な空想実験だった。

彼はこれを「イミテーション・ゲーム」と名づけた。

部屋が3つある。1つの部屋には審判員が入り、2つの部屋には女性と、男性がそれぞれ別々に入る。審判員の部屋と男性の部屋、女性の部屋はそれぞれが独立したテレタイプ端末、要はキーボードとプリンター(ディスプレイ)が接続されており、審判員にはどちらの部屋に女性が入っているかは明かされない。

審判は2つの部屋と別々にテレタイプ端末で筆談をしながら、相手が本物の女性かどうか判定する。男性は女性のふりをして審判員を欺(あざむく)くよう言われる。

審判が、女性か男性か筆談のみで見分けることができる確率をXとしよう。次に、この女性のふりをする男性を、女性のふりをするロボットに置き換えてみる。

再び審判は部屋にいるのが男性か女性かロボットかを知らされずにテレタイプ端末で筆談を行い、相手が本物の女性かどうか判断する。この確率をYとしよう。

このとき、本物の人間の男性が女性を演じているかどうか見分けることのできた確率Xと、ロボットが女性を演じているかどうか見分けることのできた確率Yが近づけば近づくほど、ロボットは人間の男性と同等の思考能力を持っていると考えられる。つまり、人工知能は完成したといえるわけだ。

このゲームは、ゲームというよりもむしろロボットが人間並みの思考能力をもっているかどうか判定するためのテストにイメージが近いため、現在では単に「チューリング・テスト」と呼ばれる。

ちなみにチューリングテストの重要な点はもう一つある。もしも人間の男性が審判を欺く確率Xを、ロボットが審判を欺く確率Yが大幅に上回ったとしたら、そのロボットは人知を超えた存在であるということになる。すなわち、シンギュラリティが達成されたというわけだ。

では、ChatGPT、もしくはBard、はたまたBingは、果たしてシンギュラリティを達成するのだろうか。少なくとも、日本人はあたかもAGIが人の仕事を奪う、これを使わない人間は格差が広がるのが必須だと言い切っている。そして世界中の人間がChatGPTを見てパニックに陥っている。日本のユーチューバーなどは危機感や恐怖感・不安といった心理テクニックを使ってるだけに過ぎないので見る人によっては精査は出来るが、ほぼ全員がそういった情報を発信してると周囲も同じようになってしまう言わば、顕在意識、潜在意識と流れ洗脳されていくので一様の注意は必要ではある。そして、人間の仕事はいよいよ奪われてしまうのではないか。もうとっくに、AIのほうが人間より賢いのではないか、と。

もちろんそんなことはない。というか、人間の賢さを現状のChatGPTやその延長線上にある技術が追い抜くのはまず不可能である。ミニ四駆だけを見て「人間が走る必要はなくなった!」と言っているようなものだ。依然として、遅刻寸前になれば人間は走る必要に迫られるのである。ミニ四駆はたしかに早いが、人間を高速に移動させてはくれない。

約60年前にもあったチャットボットが「人間を超えた」と多くの人が信じた瞬間

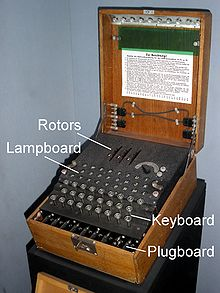

チューリングがイミテーション・ゲームを考えていた頃は、まだコンピュータというのはおそろしく原始的なものだった。原子力発電のアイデアはあっても、まだヤカンか、せいぜい焼却炉しかない時代のことだ。チューリングの機械は本質的に言葉を数学的に扱う機械だった。暗号解読を目的としていたからだ。

しかし数学で言葉や概念、関係性を扱えるというゲーデルのアイデアにチューリングは大いに刺激を受けたし、それが遠い未来にイミテーション・ゲームをパスするロボットが登場するのではないかと想像も出来る。想像が出来るということはほぼ実現出来てしまうことにもなる?

チューリングが1954年に亡くなって10年後、マサチューセッツ工科大学の人工知能研究所ではささやかな実験が行われていた。この時代にはチューリングが夢想したようなテレタイプ端末が大学にも入り、コンピュータと接続されていた。しかしこの当時のコンピュータはとても高価で巨大であるだけでなく、計算能力も極めて低かった。

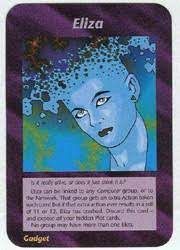

そんな中、ジョセフ・ワイゼンバウムは、一種のジョークとして、精神科医のように会話するプログラムを書いた。バーナード・ショーの戯曲「ピグマリオン」の登場人物にちなんで、「イライザ」と名づけられたそのプログラムを見たワイゼンバウムの秘書は、そこに本当の知性が宿ると確信した。

ワイゼンバウムの秘書だけが驚いたのなら問題なかった。しかし「イライザ」はあまりにも多くの人を驚かせ、混乱させ、真の知能の人工化に成功したと錯覚させた。ワイゼンバウム自身は、ジョークのつもりで作ったプログラムに真の知性を見出す人が続出し、あまりの反応に驚き、戸惑った。

2010年のインディペンデント映画「Plug & Play」で、ワイゼンバウムはこうも言っている。「イライザを誤解した人だけがそれをセンセーションと呼んだ」

2010年のインディペンデント映画「Plug & Play」で、ワイゼンバウムはこうも言っている。「イライザを誤解した人だけがそれをセンセーションと呼んだ」

イライザと聞くとどうしても、やりすぎ都市伝説を思い出してしまう(笑)

最も簡単なチャットボットでさえ、最低限の知性を備えているように見える

イライザがなぜジョークだったのか、なぜ多くの人がそれに騙されてしまったのか。

小生が以前参加していた子供にプログラミングを教える「プログラミング道場」の初級教材で、まさにこの「チャットボット」の作り方をカリキュラムに入れていた。

単純なチャットボットは、わずか二行で作ることができる。

buffer=[“こんにちは”]

buffer.push(prompt(buffer[Math.floor(buffer.length*Math.random())]))

興味がある人はこれをブラウザの開発者タブでJavaScriptコンソールを立ち上げて実行してみてほしい。

※キーボード 【F12】 キーを押すと出てくる

「こんにちは」というプロンプトが現れるので、ここに何らかの反応を入力する。例えば「どうもどうも」などだ。再び二行目のコードを打ち込む(コピペで良い)と会話を続けることができる。

これで会話するとこんな感じになる。

「こんにちは」

「どうもどうも」

「こんにちは」

「さっき聞いたよそれは」

「どうもどうも」

「挨拶はもういいからさ」

「挨拶はもういいからさ」

「うん。別の話をしよう」

「さっき聞いたよそれは」

「え、言ったっけ?」

「どうもどうも」

「君、なんかおれのこと誤魔化そうとしてない?」

「え、言ったっけ?」

「なにを?」

「うん。別の話をしよう」

これは実際の会話だが、仕組みが分かっただろうか。つまり、この最も単純なチャットボットは、ユーザーが入力した言葉を覚えておいて、単にランダムに過去の発言を選んで出しているだけなのである。

それでもある程度は会話が成立しているように見えてしまうのは、コンピュータではなく、人間が、「会話の流れ」を頭の中に作ってしまうという習性があるからだ。こうした習性はモンタージュ理論・クレショフ効果などと呼ばれる。全く無意味な言葉の羅列から、意味を見出してしまう性質である。

「そんなもの信じられるわけない」と思うかもしれない。でも、もしも原理を聞かずに、「この人の相手をしてください」と言われたらどうだろう。もしくは前置きなしに、この会話が繰り広げられたらどうだろう。例えば、耳の遠い、ちょっとボケたおじいちゃんだったら、こんなやりとりになるのではないか、と想像してしまうかもしれない。

フランスの詩人が書いた四行詩に、世界の終わりの予言を見出してしまう人もいるのだ。コンピュータが出したデタラメな受け答えを見ても、人間は勝手に自分の頭のなかで、相手の人格を見出してしまう。

これを少しだけ巧妙に作ったのがイライザだ。イライザの原理は、まず前提として、イライザは精神科医であり、やってくる人はカウンセリングにきた患者という設定を置くことにある。この設定によって、ユーザーは必然的にイライザに相談をしなければならなくなる。

例えば、イライザとの会話はこうなる。

「こんにちは。あなたのファーストネームは?」

「リョウ」

「そうですか。リョウさん。なにかお悩みがあるそうですね?」

「はい」

「どんなお悩みでしょうか?」

「実は弟がギャンブルに依存していて……」

「ギャンブルはできればやめたほうがいいでしょう」

「そうなんです。それで父と弟が喧嘩していて……」

「お父さんはどんな方ですか?」

「サラリーマンで、いまは定年しています」

「もっと聞かせてください」

「そうですね、父はエンジニアでした」

「エンジニアは素晴らしい仕事ですね。聡明さを要求される職業ですね。あなたはどんなお仕事を?」

このような具合である。この会話のトリックは極めて簡単だ。

「父」という言葉が発言に含まれていれば、「お父さんはどんな方ですか?」と聞く。「ギャンブル」という言葉が発言に含まれていれば、「ギャンブルはできればやめたほうがいいでしょう」と当たり障りのない答えを返す。エンジニアも同様。どれにもあてはらなければ、「もっと聞かせてください」など、相手の発言を引き出す定型文を投げる。

今でこそ、「定型文」というのは身近になったが、それはメールやメッセンジャーが普及しきったからだ。そんなものがない1960年代に「定型的な返しだけで会話が成立する」と想像するのは難しい。だからワイゼンバウムはすごかったのだが、同時に会話の中身がないことは作った本人がよく承知していた。

もっと複雑なこともできるが、重要なのは、それが全てトリックであるということだ。イライザは一大ブームを巻き起こし、さまざまなものに影響を与えた。

イライザを直系の祖先として持つのが、最近多くの企業が取り入れ始めた「チャットによるサポート」サービスだ。しかし一度使えば分かるが、会話を楽しむどころか、質問に的確に答えてくれることのほうが珍しい。

なぜこういうことが起きるかといえば、いまのチャットボットによるサポートは、FAQのユーザーインタフェースを少し変えただけのものだからだ。つまり、チャットボットのシナリオとして用意されていないものは、全く対応できない。一時期盛り上がったIBMのWatsonの一連のソリューションが、結局はチャットボットになり、最終的には人々を落胆させた原因でもある。

チャットボットのシナリオの記述には、例えばAIML(Artificial Intelligence Markup Language)のようなマークアップ言語が使われる場合があるが、AIMLを一度触ってみれば、これがいかに不完全なものか分かる。

2020年にAIMLをDLで独自拡張したAIIML(Artificial Illusional Inteligence Markup Language)を開発されている。開発したAIIMLは内部にspaCyやGiNZAなどを使った構文解析や、PythonやJavaScriptでの拡張が可能で、音声認識と音声合成の機能を備えていた。声で指示するだけでWikipediaを調べて読み上げたり、地図を表示したり、図を書いたりWebサイトを作らせたりすることができる。

このAIIMLでは内部でGPT-3も使っているが、GPT-3に投げるとかなり適当な答えを返してくる。以前、焼肉屋さんで実験的に導入したときは、客がおすすめの肉を聞くと別の店を紹介し始めたので慌てて止めたことがある。

イライザとChatGPTの「トリック」はどう違うのか?

イライザ、およびイライザの延長上にあるチャットボットを体験した今の世代だからこそ、ChatGPTは頭ひとつ飛び抜けたものに見えているのは無理もない。

特にChatGPTは、聞いた側が知らないことまですらすらと答えてくれる。しかし多くの人が指摘しているように、ChatGPTも、おそらくGoogleのBardも、それ以外の似たようなものも、根本的には「決して答えが信用できるというわけではない」という問題をはらんでいる。

あまり専門的になると難しい話になってしまうので、まずはなぜChatGPTが「こちらが知らないことまで答えてくれるのか」というトリックを深堀してみたい。

例えば、今年の元旦のニッポン放送のラジオ番組「生放送!AIくんと遊ぼう」で、ChatGPTに「お正月の人工知能をテーマにしたラジオ番組で流すべき曲は?」と聞くと、こんな答えが返ってきた。

これを見て筆者は「はーなるほどね」と思ったのだが、横で見ていた放送作家の方がすごく驚いていた。「AIと聞いたのにロボットの曲が返ってくるとか、凄すぎないですか?」

そうなのだ。これが「トリック」の正体である。

人間が驚く時は、「あまり関係性を意識していなかったけど、もともとは知っていた複数の概念が、なにかのきっかけで結びつくとき」である。この放送作家の先生でいえば、「AIとロボット」はまったく別の概念として捉えられており、その関係性を示されたことでびっくりした、いわば「AHA体験」につながった。

しかし、原理を知っていると、これはそれほど驚くべきことではないことが分かる。

まず、AIの学習方法について。GPT3のような自然言語系のAIの学習方法は、大量の文章を読むことである。大量の文章を読むと、そこに一緒に現れる単語は、「近い概念」として学習される。例えば「りんご」を説明する文章には「赤い」という言葉と一緒に現れる頻度が高い。

ニューラルネットワークについては、HRacademyやベイサイド本牧スポーツアカデミーでも取り上げていますので、参考迄に紹介しておきます。

「AI」という言葉と「ロボット」という言葉が一緒に現れる頻度が高いのは、AIエンジニアにとっては当たり前だが、一般の専門外の人にとっては全く別のものと捉えてる人もいる。例えば「ドラえもん」をAIだと思っている人は少ない。

ChatGPTを含む、最近のDLチャットボットのロジックの大部分は、この「知らないはずのことを知っていた!」というニューラルネットワークの仕組みでもあり、人間が聞いて納得するような関係性ならば、その単語は必ず関連付けて出てくるので何も不思議なことではない。むしろ、原理に忠実に考えると当然そのようになる結果になるのた。

次の仕組みは、「同じ回答を出さない」または「同じことを別の表現で言い換えられる」ということ。

DL系チャットボットは、文章を生成するときに、「この単語の次に出てきそうな単語はどれ?」というのをランダムに選択する。だから、同じセリフを二度返すことが少ない。これは従来のAIML的なチャットボットにはできなかった芸当で、これで人は勝手に「知性がある!」と感じ取ってしまうことになる。

※ランダムフォレスト

しかし、実際には「確率的に意味が通りそうなランダムな言葉の候補を取ってきているだけ」なので、別に内容を理解しているというわけでは全くない。ChatGPTが「それっぽいことを言うだけの実は何も考えてない人」みたいな回答をするのがそれが原因だ。

実際に何も考えていないのだから。

チャットボットに未来はあるのか?

私見と前提した上で、この競争、少々加熱しすぎではないかと思っている。実際、Googleは元々ChatGPTに対して静観しようとしていたように見える。

ところが社内から不満の声が出て、慌ててチャットベースのサービスを準備するも、早くも「答えが不正確」という批判が出てきた。原理を考えれば、答えが不正確なのは当たり前だ。だからこそGoogleはそれをコンシューマ向けに提供してこなかったのだが、一般の人はそうは思わない。

「Googleが不正確な答えを出す人工知能を発表して炎上した」と考えてしまう。これもまた一種の心理トリックだ。

論理的誤謬(ごびゅう)である。でも以前もワトソンがそうであってように!アルファーゴ。これを聞いてピンときた人は業界人ではないか?過去チェスの世界No騎士とAI(アルファーゴ)が対戦した時、偶然にもアルファーゴのバクをきっかけに勝敗が決着しているのだから。でもこの事実を知る人は一般消費者にはほぼいない。(だろう)

Microsoftはこの機を逃すなとばかりにBingにChatGPTを搭載すると発表した。もともとBingのユーザーはそれほど多くないので、これが即座に世界中を混乱に陥れるとは思えないが、やはり知識のない人が過度に会話AIに期待すると、あまりに不正確な情報が出てきてガッカリ、ということになりかねない。

この状況をAIエンジニアが危惧するのは、これが「AIの冬」を呼び起こさないかという不安だ。昔も今も変わらない構図ではあるが、昔と今では精度も違うがはやり世はアウフヘーベンのようだ。

Googleほどの会社が不正確な答えを返すAIを提供するとしたら、世界の誰も正確な答えを出すAIが作れないのではないかという誤解が広まってしまい、それがAI産業全体を地盤沈下させる可能性がある。実際、Googleのチャットボットが不正確だというニュースだけで、株価が10%近く下落したそうだ。世間のAIに対する認識はそれほど誤解に満ちており、この誤謬によって第三のAIの冬が到来したとしても不思議ではない。

2000年にシリコンバレーで起きた「ドットコム・クラッシュ」は、まさに「ドットコム企業(IT企業)」に対する過度な期待への失望から、株価が大幅に低迷し、あちこちで悲惨な倒産劇が生まれた。

実際問題、いま「AI企業」と名乗る会社は玉石混交で、AIに対する正確な知識の裏付けがあるわけでもない。何でもAIで解決しようとした結果、アウトカムにつながらないPoC(概念検証)を焼畑農業のように繰り返すだけの会社も、大手含めて少なくない。

ただし、これは痛みは伴うものの、業界の健全化という視点から見れば歓迎すべき事態だ。ここで生き残るのは、本当に価値のあるAIを開発する企業だけになっていくだろう。

ドットコム・クラッシュが起きても、立ち上がってきた会社が、まさにAmazonやGoogle、Netflixである。1990年代末期には無数のドットコム企業があったが、2000年のドットコムクラッシュによって中途半端な会社はすべて淘汰された。AI業界も再編を迫られることは間違いないだろう。

それでも、チャットボットに可能性があると思う理由

筆者自身が分析するには、医学でもそうだがアウフヘーベンしていくことには変わらない。

よって時間の経過とともにまた変わりゆくものが開発されてくると信じている。

アレクサ、シリなども一般的になり、毎日のようにチャットボットで対話をしてる人達もいる。私も以前、子育て世代のお悩み相談に乗ったとき、相談者に絵本等の読み聞かせを抑揚を付けて感情豊かに接することをすすめた。

で、その両親の言葉を借りると、娘さんは毎日アレクサに話かけては遊んでいるとのことだった。

誰もこれがチャットボットだと意識していないが、毎日、チャットボットに起こされ、天気を尋ね、今日の格言や占いや、気温を訪ねている。そう、Alexaが当たり前の時代になってるということだ。介護現場でも老人のボケ防止等にも貢献してるのでものは使いようである。

人間にとって、最も自然なインターフェースは、会話である。赤ん坊の頃から、会話することでしか人は自分の意思を伝えられない。コンピュータを使うのはどこまでいっても特殊な人だ。プログラミング教育が義務教育に入ったとしても、会話そのものはどこからもなくならない。

Alexaのすごいところは、老人でも使えることだ。機械音痴で問題ない。或いは私の母は楽脳梗塞を患い酷い時は会話がままならずうまく発音することができないし、文字を組み合わせて単語を作ることさえ苦労していた。

ところが、Alexaは使えるのである。

「アレクサ、今日の天気」

という本当に短い単語を二つ三つ言えば、天気を教えてくれる。

「アレクサ、明日の朝八時に起こして」

と言えば、起こしてくれる。

今、スマートスピーカーはどちらかというと下火で、AmazonもAlexaから直接収益を得ることに成功していないが、間違いなく最も身近なチャットボットはAlexaとSiriだろう。

GoogleやMicrosoftが本質的に警戒しているのは、SiriやAlexaのように既に人間の生活に密着したチャットボットが、OpenAIのChatGPT並みの自然(に聞こえるようなトリックを有した)な受け答えと、Pexplexity.aiのような出典に基づく検索結果を示してしまうようなとき、もはや誰も検索など必要としなくなってしまうということだろう。

実際、Alexaは今のところ「いい感じに低機能」である。難しいことを聞いてもあんまり答えてくれないし、答えに対する質問も受け付けない。それはイライザが過度な期待を集めた結果、大きな失望(作者にすれば当然の理解)を生んだことを踏まえ、最初から過度な期待をさせないように巧妙にマーケティングしてきたからだ。

OpenAIのChatGPTは真逆で、まず「すごいでしょ」というマーケティング戦略を取った。これにつられてGoogleは(たぶん開発者は重々承知していたはずだが)不正確な答えを出すチャットボットをリリースしてしまい、炎上して時価総額を1000億ドルほど下げた。Alexaは決してOpenAIよりも劣っていたのではない。こうなることが分かっていたから、「過度な期待をもたせない」ようにしていたのだ。

しかし、AlexaやSiriがPerplexity.aiに似た機能を搭載するほうが、みんなが検索エンジンを使うのをやめてBingとチャットするようになるよりも、ずっと自然だし簡単ではないだろうか。

Alexaのよくできたところは、会話のトリックを非常に注意深く、しかも効果的に取り入れていることだ。今のところ最もセンスのいいチャットボットだといえる。

いずれにせよ、チャットボットなど新しいテクノロジーが盛り上がるのは歓迎したいが、安易にブームに乗ると本質を見誤ることは指摘しておきたい。

そう、私が学生に何時も言っているのが【本質を理解し、学ぶ事】と話している。

上辺だけ、見えてるところだけで判断しない。顕在意識、潜在意識の話しではないが、より本質を見極めるスキルが必要になってくる時代だと改めて感じた一幕である。

そこでやはりおすすめしたいのが、人間という動物がどういう生き物なのかの基本を著書の独自の観点でまとめたサイトが下記の『HRacademy』である。ここでは、神経科学(俗に言う脳科学)、心理学、人生成功哲学、解剖学などの分野を初心者向け、といっても馴染みが無い人には少々難しく感じる場面もあると思料するが、日常生活で見聞きしてるものは様々なものに置き換えてみると○○だということも想像し理解が出来てくるようにまとめているので、興味が沸いたら見て頂きたい。

この記事が参考になったよ!と言う方は是非、下記の星マークで評価をお願いしたい。